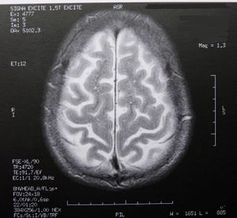

Gehirnforschung: Globale Datenflut wird koordiniert

Archivmeldung vom 24.11.2016

Bitte beachten Sie, dass die Meldung den Stand der Dinge zum Zeitpunkt ihrer Veröffentlichung am 24.11.2016 wiedergibt. Eventuelle in der Zwischenzeit veränderte Sachverhalte bleiben daher unberücksichtigt.

Freigeschaltet durch Thorsten SchmittDie 2013 von der US-Administration ins Leben gerufene Initiative "Brain Research through Advancing Innovative Neurotechnologies" (BRAIN) hat eine Unmenge an neuen Daten zur Erforschung der Funktionsweise des menschlichen Gehirns gebracht. Für Kristofer Bouchard vom Lawrence Berkeley National Laboratory ist es jedoch nötig, dass dieser Flut an Informationen auch eine einheitliche Strategie zu Analyse, Management und Verständnis gegenübersteht.

Bouchard hat ein internationales Team aus Wissenschaftlern zusammengestellt, um einen Plan für das Management, die Analyse und das Teilen der Ergebnisse zu erstellen. Die Empfehlungen der Mathematiker, Computer- und Neurowissenschaftler sowie Physiker wurden im Fachmagazin "Neuron" veröffentlicht. Laut dem Fachmann handelt es sich bei BRAIN nur um eine der zahlreichen nationalen und privaten Initiativen im Bereich der Neurowissenschaft, die weltweit daran arbeiten, rascher mehr Wissen über das menschliche Gehirn anzusammeln.

"Zahlreiche dieser Anstrengungen haben sich auf die technologischen Herausforderungen des Messens und der Manipulation neuronaler Aktivität konzentriert. Viel weniger Augenmerk wurde auf die Herausforderungen gelegt, die im Umgang mit diesen riesigen Datenmengen zum Beispiel im Bereich der Computer entstehen." Um die Rendite der weltweiten Investitionen zu maximieren, argumentieren die Experten, dass die internationale Wissenschafts-Community über eine ganzheitliche Strategie für das Datenmanagement und die Datenanalyse verfügen sollte.

Gemeinsamer Standard nötig

In einem ersten Schritt sollen sich Wissenschaftler aller Bereiche der Neurowissenschaft für die Ergebnisse der Datenanalysen und Simulationen auf Standardbeschreibungen und Dateiformate einigen. In einem nächsten soll gemeinsam mit Computerwissenschaftlern an Hard- und Software-Ökosystemen für das Archivieren und Teilen von Daten gearbeitet werden. Die Forscher plädieren hier für ein ähnliches Ökosystem wie es von den Physikern für das Teilen der Forschungsergebnisse der Experimente des CERN-Teilchenbeschleunigers Large Hadron Collider bereits eingesetzt wird.

Quelle: www.pressetext.com/Michaela Monschein