System konvertiert 3D für brillenlose Displays

Archivmeldung vom 17.12.2015

Bitte beachten Sie, dass die Meldung den Stand der Dinge zum Zeitpunkt ihrer Veröffentlichung am 17.12.2015 wiedergibt. Eventuelle in der Zwischenzeit veränderte Sachverhalte bleiben daher unberücksichtigt.

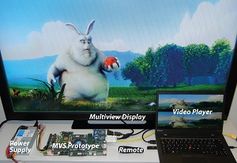

Freigeschaltet durch Thorsten SchmittKlassische stereoskopische 3D-Inhalte sind für die zunehmend aufkommenden brillenlosen 3D-Displays eigentlich nicht geeignet. Doch Forscher von Disney Research und der ETH Zürich http://ethz.ch haben nun ein System aus Algorithmen und Hardware entwickelt, das existierende 3D-Videos in Echtzeit geeignet für die autostereoskopischen Multi-View-Bildschirme umwandelt.

Die zur IEEE International Conference on Visual Communications and Image Processing vorgestellte Lösung könnte dem Team zufolge auch in ein System-on-a-Chip (SoC) integriert werden, womit sie für mobile Anwendungen geeignet ist. Multi-View-Displays stellen mehrere - gängigerweise fünf bis neun - Perspektiven gleichzeitig dar, damit ein 3D-Genuss ohne Brille möglich wird.

"Um das volle Potenzial dieser neuen 3D-Technologie auszuschöpfen, brauchen wir auch Content, den es in diesem Format bislang praktisch nicht gibt", betont Markus Gross, Leiter des Disney-Research-Labors in Zürich. Denn existierende 3D-Filme umfassen normalerweise nur zwei Bildperspektiven, die dank einer Brille zum 3D-Erlebnis werden. Das neue System wandelt solche Inhalte so um, dass sie für die neuen, brillenlosen Displays geeignet sind.

Sinnvolle Verzerrung

Dabei setzt das Team laut Michael Schaffner, Doktorand bei Disney Research und an der ETH Zürich, auf eine "Image Domain Warping" (IDW) genannte Methode. Dabei analysiert das System die beiden existierenden Bildperspektiven nach herausragenden Merkmalen, einander entsprechenden Punkten und Kanten. Durch Lösen einer mathematischen Optimierungsaufgabe ist es dann möglich, neue Bildperspektiven zwischen den beiden ursprünglichen zu berechnen.

Diese "Warps", eigentlich "Verzerrungen", versprechen den Forschern zufolge eine bessere Bildqualität als Ansätze, die aus den Originalansichten eine Tiefenkarte zu erstellen versuchen. Obwohl der IDW-Ansatz rechenintensiv ist, schafft das System dank der Hardware-Architektur des Teams vollautomatisch acht neue Perspektiven in Echtzeit und HD-Qualität.

Seines Wissens nach sei es die erste Hardware-Umsetzung eines derart leistungsfähigen IDW-Systems, so Schaffner. Dabei scheint eine sehr kompakte Umsetzung möglich. "Die Hardware könnte als energieeffizienter Koprozessor in ein SoC integriert werden", erklärt der ETH-Doktorand. Damit erscheint die Echtzeit-Umwandlung von 3D-Inhalten auch in mobilen Geräten, wie beispielsweise Smartphones, möglich.

Quelle: www.pressetext.com/Thomas Pichler